Vous travaillez avec Netty et vous vous demandez comment gérer correctement une netty connection, pour éviter les fuites de ressources, les timeouts ou les blocages difficiles à déboguer ? La réponse tient en trois axes : bien comprendre le cycle de vie d’un canal, configurer les bonnes options de connexion, et surveiller les performances en production. Dans ce guide, vous trouverez rapidement les bonnes pratiques essentielles, puis des explications plus détaillées pour fiabiliser vos serveurs et clients Netty.

Comprendre le fonctionnement d’une netty connection dans votre application

Avant d’optimiser quoi que ce soit, il est crucial de comprendre comment Netty crée, gère et ferme les connexions TCP. Cela vous aidera à diagnostiquer les erreurs courantes comme les connection reset, les inactive channel ou les fuites de Channel. Cette première partie pose les bases concrètes dont vous aurez besoin pour les optimisations à venir.

Du bootstrap au channel actif : comment naît une connexion Netty côté serveur

Lorsqu’un serveur Netty démarre, le ServerBootstrap se charge de lier un port et d’accepter les connexions entrantes. Pour chaque client qui se connecte, Netty crée automatiquement une instance de Channel qui représente cette connexion spécifique. Cette instance passe par un ChannelPipeline, une chaîne de handlers qui traite les événements entrants et sortants.

Le ChannelPipeline contient plusieurs ChannelHandler qui s’exécutent séquentiellement. Chaque handler peut intercepter des événements comme channelActive (déclenché quand la connexion est établie) et channelInactive (déclenché quand elle se termine). Ces événements vous permettent d’initialiser des ressources au démarrage de la connexion et de les libérer proprement à sa fermeture.

La gestion des threads dans Netty repose sur les EventLoopGroup. Le serveur utilise généralement deux groupes : un pour accepter les connexions (boss group) et un autre pour traiter les I/O de chaque channel (worker group). Cette séparation évite qu’une opération bloquante sur un client ne retarde l’acceptation de nouvelles connexions. Comprendre ce mécanisme est essentiel car une mauvaise utilisation du thread event loop peut bloquer toutes les connexions gérées par ce thread.

Comment une connexion Netty côté client est établie et surveillée dans le temps

Côté client, la création d’une connexion démarre avec Bootstrap.connect(). Cette méthode retourne immédiatement un ChannelFuture, un objet qui représente le résultat futur de l’opération de connexion. Comme l’établissement de la connexion est asynchrone, vous devez ajouter des listeners sur ce ChannelFuture pour savoir quand la connexion est réellement établie ou a échoué.

Un exemple typique pour vérifier qu’une connexion est active ressemble à ceci : après avoir appelé connect(), vous attachez un listener qui vérifie channel.isActive(). Si la connexion échoue, vous pouvez implémenter une logique de reconnexion avec un délai exponentiel pour éviter de surcharger le serveur distant.

Pour un client qui ne se connecte qu’une seule fois (one-shot), la gestion est simple : on se connecte, on envoie les données, on reçoit la réponse et on ferme. En revanche, pour un client long-lived qui maintient une connexion permanente, vous devez surveiller la connexion en continu. Les handlers comme IdleStateHandler permettent de détecter quand aucune donnée n’est échangée pendant un certain temps et de déclencher une reconnexion si nécessaire.

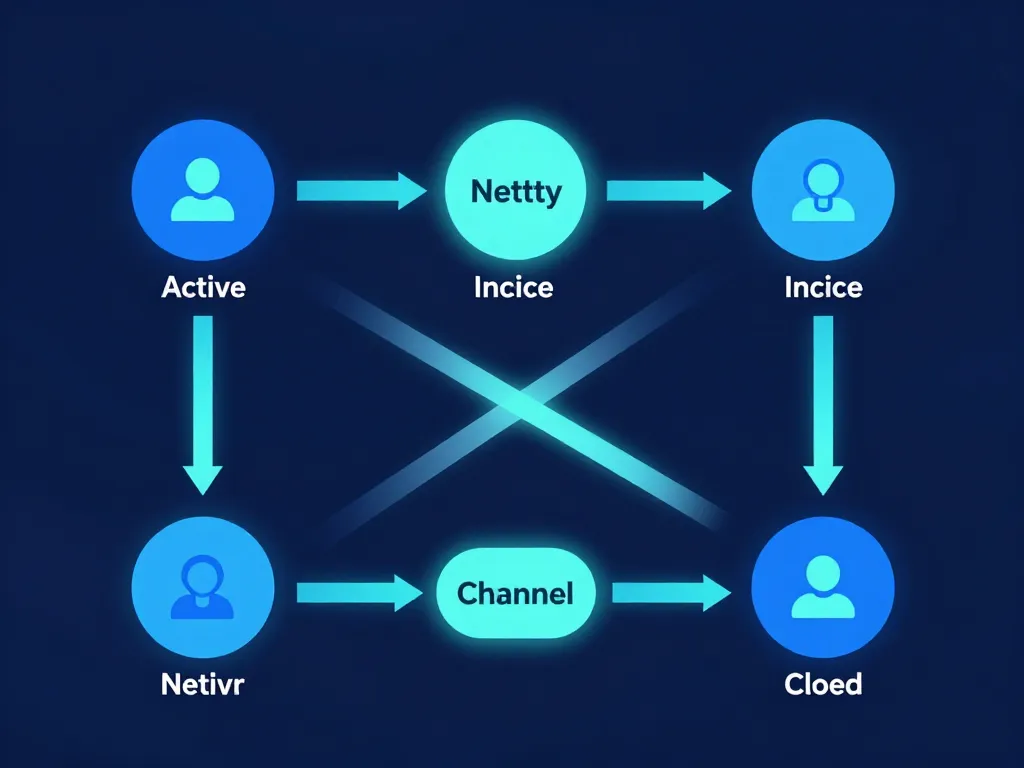

Que signifient vraiment les états active, inactive et closed d’un Channel Netty

Un Channel dans Netty traverse plusieurs états durant son cycle de vie. L’état active indique que la connexion TCP est établie et prête à échanger des données. À ce moment, vous pouvez écrire et lire sur le channel sans problème. L’événement channelActive est le bon endroit pour initialiser des ressources ou envoyer un message de handshake applicatif.

Quand la connexion est fermée par l’une des parties, le channel passe à l’état inactive. L’événement channelInactive est déclenché, vous permettant de libérer les ressources associées comme des timers ou des buffers. C’est aussi le moment d’enregistrer des métriques sur la durée de vie de la connexion.

L’état closed signifie que le channel a été complètement fermé et ne peut plus être réutilisé. Tenter d’écrire sur un channel fermé ou inactif provoque généralement une exception ou un échec silencieux, d’où l’importance de toujours vérifier channel.isActive() avant d’envoyer des données. Les erreurs typiques incluent l’envoi de messages après la fermeture, ce qui génère des exceptions dans les logs sans que l’application ne semble planter immédiatement.

Configurer une netty connection stable et performante en pratique

Une netty connection mal configurée entraîne très vite des latences, des timeouts ou des erreurs aléatoires difficiles à reproduire. En ajustant correctement les options de canal, les timeouts et la gestion des buffers, vous gagnez en robustesse sans surcomplexifier votre code. Cette partie vous guide sur les réglages concrets qui font vraiment la différence.

Quels paramètres de connexion Netty ajuster pour fiabiliser vos canaux TCP

Netty expose plusieurs options TCP que vous pouvez ajuster via le ServerBootstrap ou Bootstrap. L’option SO_KEEPALIVE active les keep-alive TCP au niveau du système d’exploitation. Elle permet de détecter les connexions mortes qui n’ont pas été fermées proprement. Activez-la sur les connexions long-lived pour éviter d’accumuler des channels fantômes.

L’option TCP_NODELAY désactive l’algorithme de Nagle, qui regroupe les petits paquets TCP avant l’envoi. Pour des applications sensibles à la latence, comme les services temps réel ou les APIs REST à faible charge, activez TCP_NODELAY pour que chaque message parte immédiatement. En revanche, si votre serveur traite massivement des petits paquets, laisser Nagle activé peut réduire l’overhead réseau.

L’option SO_BACKLOG définit la taille de la file d’attente des connexions en attente d’acceptation côté serveur. Pour un serveur à fort trafic avec des pics de connexions simultanées, augmenter cette valeur (par exemple à 1024 ou plus) évite de rejeter des connexions légitimes. Enfin, CONNECT_TIMEOUT_MILLIS contrôle le délai maximum pour établir une connexion côté client. Réglez-le en fonction de la latence réseau attendue : 3000 ms pour un réseau local, 10000 ms pour des connexions internet.

| Option | Cas d’usage | Valeur suggérée |

|---|---|---|

| SO_KEEPALIVE | Connexions long-lived | true |

| TCP_NODELAY | Faible latence | true |

| SO_BACKLOG | Serveur fort trafic | 1024+ |

| CONNECT_TIMEOUT_MILLIS | Réseau instable | 10000 |

Gérer les timeouts Netty sans casser l’expérience utilisateur ni surcharger le réseau

Netty propose trois handlers de timeout essentiels : ReadTimeoutHandler, WriteTimeoutHandler et IdleStateHandler. Le ReadTimeoutHandler déclenche un événement si aucune donnée n’est lue pendant un délai donné. C’est utile pour détecter un client ou serveur qui ne répond plus. Configurez-le en fonction de votre logique métier : si vous attendez une réponse sous 30 secondes, réglez-le à 35 secondes pour laisser une marge.

Le WriteTimeoutHandler fonctionne de manière symétrique pour les écritures. Il détecte les situations où les données ne peuvent pas être envoyées, souvent à cause d’un réseau saturé ou d’un client lent à consommer. Attention cependant : un timeout d’écriture trop court sur un réseau lent peut provoquer des déconnexions prématurées.

L’IdleStateHandler est le plus flexible : il détecte l’inactivité en lecture, en écriture ou les deux. Par exemple, vous pouvez configurer un idle de 60 secondes et envoyer un ping applicatif pour maintenir la connexion vivante. Quand un timeout se déclenche, fermez la connexion proprement dans votre handler en loggant suffisamment d’informations (durée de connexion, dernière activité, raison du timeout) pour faciliter le support technique.

Allocation des buffers et options de ByteBuf pour une connexion Netty plus efficace

Netty utilise des ByteBuf pour gérer les données en mémoire. Par défaut, Netty alloue les buffers via un PooledByteBufAllocator, qui réutilise des buffers pour éviter les allocations fréquentes et réduire la pression sur le garbage collector. En production, cette option améliore significativement les performances sous charge.

Vous pouvez aussi utiliser Unpooled pour des allocations ponctuelles, mais cela convient surtout aux cas simples ou aux tests. Pour dimensionner correctement les buffers, analysez la taille typique de vos messages. Si vos messages font 4 Ko, réglez les tailles de buffer initiales à cette valeur pour éviter les réallocations. Une valeur trop grande gaspille de la mémoire, une valeur trop petite force des copies et des agrandissements répétés.

Le point critique avec les ByteBuf est leur libération. Netty utilise un comptage de références : chaque ByteBuf doit être explicitement libéré via release(). Oublier cette étape provoque des fuites mémoire qui s’accumulent au fil du temps. Utilisez l’outil ResourceLeakDetector de Netty en développement pour repérer ces fuites rapidement. En production, laissez-le en mode SIMPLE pour un overhead minimal.

Bonnes pratiques pour gérer le cycle de vie et la fermeture des connexions Netty

Une des grandes sources de bugs avec Netty vient d’une fermeture de connexion mal gérée ou d’un cycle de vie incompris. En appliquant quelques règles simples sur la fermeture des Channel, la gestion des exceptions et le partage des EventLoopGroup, vous évitez des comportements fantômes en production. Cette partie rassemble les pratiques qui reviennent le plus souvent dans les retours d’expérience.

Comment fermer proprement une netty connection sans fuites ni erreurs fantômes

Pour fermer une connexion Netty, appelez channel.close(). Cette méthode retourne un ChannelFuture que vous pouvez écouter pour savoir quand la fermeture est effective. Fermer un channel déclenche l’événement channelInactive dans vos handlers, où vous devez libérer toutes les ressources associées : buffers, timers, tâches planifiées.

Utilisez closeFuture() pour attendre la fermeture complète. Par exemple, dans un client, vous pouvez appeler channel.closeFuture().sync() pour bloquer jusqu’à ce que la fermeture soit terminée avant de fermer les EventLoopGroup. Cela garantit que toutes les ressources sont libérées dans le bon ordre.

Les symptômes d’une fermeture incomplète incluent des threads qui ne s’arrêtent jamais, des logs d’erreur qui apparaissent plusieurs secondes après la fermeture supposée, ou des compteurs de connexions actives qui restent élevés. Assurez-vous aussi de fermer les EventLoopGroup avec shutdownGracefully() pour arrêter proprement tous les threads associés.

Gérer les exceptions de connexion Netty pour éviter les plantages silencieux

Tous vos handlers doivent implémenter la méthode exceptionCaught. C’est elle qui intercepte les exceptions non gérées dans le pipeline. Sans elle, une exception peut tuer silencieusement le channel sans que vous ne sachiez pourquoi la connexion a été fermée.

Dans exceptionCaught, loggez toujours l’exception avec un niveau approprié. Les erreurs réseau « normales » comme IOException: Connection reset by peer méritent un log en INFO ou DEBUG, car elles reflètent simplement qu’un client s’est déconnecté brutalement. En revanche, des exceptions applicatives (erreur de parsing, état incohérent) doivent être loggées en ERROR et éventuellement remonter une alerte.

Proposez un schéma simple : pour chaque exception, décidez si la connexion doit être fermée ou non. Par exemple, une erreur de décodage peut fermer le channel pour éviter de propager des données corrompues, tandis qu’une erreur temporaire peut juste être loggée. Uniformisez ce traitement dans un handler dédié pour éviter la duplication de code dans toute votre pipeline.

Mutualiser EventLoopGroup et ressources pour des milliers de connexions concurrentes

Les EventLoopGroup représentent un pool de threads qui gèrent les I/O. Créer un EventLoopGroup par connexion serait catastrophique en termes de consommation CPU et mémoire. Au lieu de cela, partagez un seul EventLoopGroup entre tous vos clients ou serveurs au sein d’une même application.

Par exemple, si vous avez plusieurs services Netty dans la même JVM, créez un EventLoopGroup global au démarrage de l’application et injectez-le dans chaque Bootstrap. Cela réduit drastiquement le nombre de threads et améliore l’évolutivité. Avec un EventLoopGroup configuré avec 8 threads, vous pouvez gérer plusieurs milliers de connexions concurrentes sans problème.

Dimensionnez le nombre de threads en fonction du nombre de cœurs CPU disponibles. Une règle courante consiste à utiliser 2 fois le nombre de cœurs pour les workloads I/O-bound. Sur une machine avec 4 cœurs, commencez avec 8 threads et ajustez en fonction des mesures de charge CPU. Évitez de créer trop de threads, car le context switching deviendrait un goulot d’étranglement.

Surveiller, déboguer et optimiser les netty connections en production

Une fois votre application déployée, les problèmes de netty connection apparaissent souvent sous la forme de pics de latence ou de déconnexions inexpliquées. En instrumentant Netty, en lisant les bons logs et en mesurant quelques indicateurs, vous pouvez rapidement isoler les goulots d’étranglement. Cette dernière partie aborde la surveillance continue et le tuning fin pour un environnement de production exigeant.

Comment diagnostiquer une connexion Netty lente ou qui se bloque parfois

Quand une connexion devient lente, commencez par mesurer le temps de handshake : combien de temps entre l’appel à connect() et le déclenchement de channelActive ? Si ce délai est anormalement long, le problème vient du réseau ou du serveur distant qui met du temps à accepter la connexion.

Mesurez ensuite la latence moyenne entre l’envoi d’une requête et la réception de la réponse. Instrumentez vos handlers pour enregistrer ces timestamps. Si la latence est élevée uniquement sur certaines connexions, comparez les configurations réseau (MTU, congestion) de ces clients spécifiques.

Activez les logs Netty au niveau DEBUG pour observer le détail des événements du pipeline. Cherchez des patterns comme des événements channelReadComplete qui ne sont jamais suivis d’un channelRead, signe que des données sont perdues. Utilisez aussi des handlers dédiés au profilage qui mesurent le temps passé dans chaque handler. Si un handler bloque longtemps, c’est probablement là que se situe le problème, souvent une opération synchrone bloquante dans l’event loop.

Instrumenter vos netty connections avec des métriques et traces observables

Intégrer Netty avec Micrometer permet d’exposer facilement des métriques vers Prometheus, Grafana ou d’autres systèmes de monitoring. Créez des compteurs pour le nombre de channels actifs, le nombre de connexions ouvertes et fermées par seconde, et le taux d’erreur dans exceptionCaught.

Ajoutez des histogrammes pour mesurer le temps de traitement dans vos handlers. Cela vous permet de détecter des régressions de performance après un déploiement. Par exemple, si le p99 du temps de traitement passe de 50 ms à 200 ms, vous savez immédiatement qu’un changement a dégradé les performances.

Pour une traçabilité complète, intégrez OpenTelemetry dans vos handlers. Chaque requête reçoit un identifiant de trace qui traverse tous les handlers et services. Cela permet de reconstruire le parcours complet d’une requête et d’identifier où le temps est perdu. Reliez ces métriques à des tableaux de bord avec des alertes automatiques : si le nombre de connexions actives dépasse un seuil ou si le taux d’erreur grimpe, vous êtes notifié avant que les utilisateurs ne subissent l’impact.

Quels ajustements appliquer quand vos netty connections saturent en charge réelle

Quand vos connexions saturent, plusieurs leviers existent. D’abord, vérifiez la taille des pools de threads dans vos EventLoopGroup. Si vos threads sont constamment à 100 % CPU, augmentez leur nombre ou optimisez le code qui tourne dans l’event loop pour éviter les opérations bloquantes.

Ensuite, implémentez du backpressure si vos clients envoient des données plus vite que vous ne pouvez les traiter. Netty propose des mécanismes comme channel.config().setAutoRead(false) pour arrêter temporairement la lecture et laisser le temps au système de traiter le backlog.

Si nécessaire, limitez le débit entrant avec des rate limiters au niveau applicatif. Cela protège votre système contre les rafales de trafic tout en offrant une expérience dégradée mais fonctionnelle aux utilisateurs. Testez toujours ces changements via des tests de charge avec des outils comme Gatling ou JMeter avant de les déployer en production. Un cas typique : un serveur qui gérait 5000 connexions simultanées a saturé après un simple changement de configuration d’un buffer trop petit. En augmentant la taille des buffers et en ajustant le nombre de threads, la capacité est passée à 15000 connexions sans changer une ligne de code métier.

Maîtriser les netty connections demande de comprendre le cycle de vie des channels, de configurer finement les options réseau et de surveiller activement vos métriques en production. En appliquant les pratiques de ce guide, vous éviterez les pièges classiques et construirez des applications réseau robustes et performantes. Prenez le temps de tester chaque configuration dans un environnement proche de la production, et n’hésitez pas à instrumenter largement pour détecter les anomalies avant qu’elles ne deviennent critiques.

- Netty connection : guide complet pour gérer efficacement les connexions - 12 janvier 2026

- Lmnp revente plus value amortissement 2025 : ce qui change vraiment - 12 janvier 2026

- Toulon quartier à éviter : comprendre les risques sans céder aux clichés - 11 janvier 2026